|

Voir l'état des eaux et son évolution - rivières et aquifères

|

Petit lexique pour comprendre les données sur l’eau

Cet article présente les termes liés à la description des données brutes et aux méthodes d’évaluation des données synthétiques. La terminologie concernant la production et le stockage des données brutes est présentée dans l’article Les données sur l’eau douce continentale : des producteurs aux utilisateurs.

Exemple : l’eau brute est traitée dans une station de traitement de l’eau potable avant d’être distribuée. L’eau au robinet est de l’eau traitée.

La limite de quantification (LQ) est la plus petite concentration à partir de laquelle on peut quantifier la substance avec une incertitude acceptable.

La LQ peut être de 3 à 10 fois supérieure à la LD.

En matière de limites analytiques, l'information "< LD" ou "< LQ" contenue dans les données brutes sur l'eau ne correspond malheureusement pas aux définitions théoriques des limites de détection (LD) ou de quantification (LQ) : "En pratique, les laboratoires ne font pas la distinction entre limite de détection et limite de quantification et la seule information disponible aujourd’hui est la limite de quantification" (SOeS 2010). Il est nécessaire d'en tenir compte lorsque l'on souhaite analyser et exploiter ces données.

Exemple : on a quantifié 3 µg/L de Glyphosate dans l’eau. On devrait préciser : 3 ± 0,6 µg/L. Car la concentration réelle n’est pas forcément de 3 µg/L. on peut seulement affirmer qu’elle est comprise entre 2,4 µg/L et 3,6 µg/L.

L’incertitude analytique devrait aussi s’appliquer aux limites analytiques.

La réglementation fixe des seuils à ne pas dépasser. Ils correspondent le plus souvent à des usages (classe de qualité "bonne" pour le SEQ eau potable) mais peuvent être ou du moins paraître patrimoniaux (classe de qualité "bonne" pour le SEQ patrimonial eau souterraine, "bon état chimique" pour la DCE, etc.).

Les seuils patrimoniaux ne sont donc pas établis par l'usage auquel on destine la ressource, par le montant des travaux à faire pour être respectés, ou par toute autre vision anthropocentrique. Ils doivent prendre en compte tous les aspects de la connaissance scientifique des écosystèmes aquatiques, des relations entre l'état des eaux et le maintien de la biodiversité, etc. Ce qui se traduit forcément par des valeurs très basses.

Il y a schématiquement deux types de méthodes complémentaires pour l’évaluation de la qualité chimique à partir des données brutes sur l’eau :

-De façon à être accessibles à tous les gestionnaires, les méthodes utilisées pour les évaluations réglementaires sont généralement des techniques de calculs assez simplistes (moyenne annuelle, percentile 90, etc.) avec des critères de sélection tout aussi simplistes (4 mesures de pesticides par an, etc.). Pour pouvoir évaluer des tendances, il est souvent fait appel à une gradation des détériorations selon plusieurs classes de qualité préétablies (5 classes du SEQ, 5 classes pour l'état écologique de la DCE, etc.). Mais il ne faut pas confondre les objectifs en terme de dépassement de seuils avec le principe de l'utilisation de classes de qualité qui permettraient éventuellement de calculer des tendances acceptables à condition qu'elles soient bien conçues, qu'elles aient du sens et que les limites de ces classes soient patrimoniales et donc suffisamment basses.

-Les méthodes utilisées pour les évaluations patrimoniales font appel à l'arsenal des méthodes modernes de la statistique et de l'analyse des données multidimensionnelles pour visualiser et analyser les niveaux de contamination et leurs évolutions. Ce qui n’empêche nullement de comparer les niveaux de dégradation ainsi obtenus aux seuils réglementaires.

Les approches type "SEQ" ou "bon état chimique" DCE sont des approches de gestionnaire orientées vers l'efficacité à court terme. Elles sont faciles à mettre en œuvre et ne demandent pas une surveillance très lourde. Mais en contrepartie, elles restent très peu performantes et pertinentes, particulièrement pour les micropolluants. Elles ne peuvent donc être qu'un complément de l'approche patrimoniale "statistique et analyse des données" qui est la seule approche réellement adaptée à la gestion sur le long terme d’une ressource patrimoniale. Cette approche patrimoniale permet la connaissance approfondie de la ressource et la compréhension du fonctionnement et des évolutions à long terme des écosystèmes. Elle permet de mettre en évidence la dégradation des milieux par rapport à l'état de référence qui est "zéro contamination" pour les polluants chimiques synthétiques, ou d'établir un lien entre les substances chimiques et les phénomènes de toxicité constatés. Elle exige malheureusement une surveillance extrêmement complète et précautionneuse, avec en particulier l'utilisation de limites analytiques les plus basses possibles, de fréquences de mesures élevées et adaptées à la variabilité des concentrations, etc.

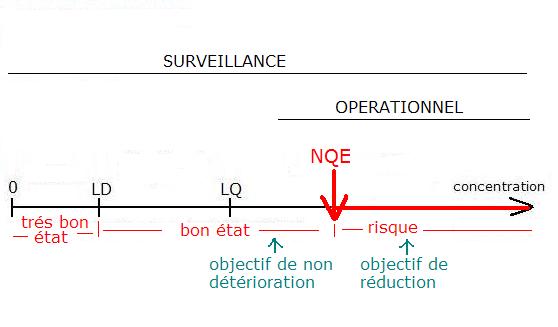

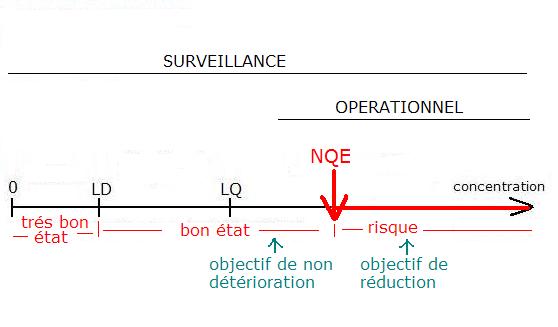

La norme de qualité environnementale (NQE) est "la concentration d'un polluant ou d'un groupe de polluants dans l'eau, les sédiments ou le biote qui ne doit pas être dépassée, afin de protéger la santé humaine et l'environnement" (Directive n° 2000/60/CE du Parlement européen et du Conseil du 23 octobre 2000 établissant un cadre pour une politique communautaire dans le domaine de l'eau).

Pour chaque substance, la LQ devrait être très inférieure à la NQE de façon à pouvoir être suivre l’évolution de la contamination et prendre les mesures nécessaires.

Quelques observations sur ces normes :

Elles ont un caractère assez empirique et évolutif.

On ne connaît en réalité pas grand chose en écotoxicologie des milieux aquatiques, que ce soit pour évaluer la toxicité à court et à long terme ou la biodisponibilité des micropolluants ainsi que leur comportement dans l'eau.

Et en admettant que l'on ait tout pris en compte pour définir un seuil de toxicité, le changement climatique avec en particulier les changements des températures et des débits remettra tout en question : la toxicité sera forcément plus importante à température de l'eau plus élevée et moins d'oxygène dissous dans l'eau, la température influencera aussi la biodisponibilité, etc.

Les PNEC et les NQE sont souvent extrapolées à partir des maigres données existantes sur un nombre très limité d'organismes aquatiques, avec un facteur de sécurité arbitraire pour prendre en compte les impacts possibles sur les autres organismes. Elles doivent être réajustées en fonction des nouvelles études. De plus, ces données résultent souvent d'essais in vitro, avec de l'eau filtrée. La réalité de la toxicité in situ peut être très différente. Et enfin, et surtout, elles ne tiennent pas compte des effets synergiques dus à la présence de plusieurs toxiques dans l'eau, ou à des facteurs climatiques particuliers.

Une étude de l'Agence de l'Eau RMC précise : "Quelque soit la méthode mise en œuvre pour classer les substances et évaluer leur dangerosité, la qualité des informations écotoxicologiques est un point clé de l'évaluation du risque. A ce jour ce sont essentiellement des données issues de biotests réalisés sur un petit nombre d'organismes aisément accessibles aux expérimentations qui sont utilisées. Ces données à la base du calcul de la PNEC sont ensuite corrigées d'un facteur de sécurité (entre 10 et 1000) pour tenir compte de la faible représentativité des données biologiques disponibles. En effet, par exemple, pour les substances existantes et largement présentes dans l'environnement on ne dispose encore trop souvent que de rares informations sur leur écotoxicité et le plus souvent sur des effets létaux. Une récente étude de l'agence de protection de l'environnement américaine a ainsi conclu que pour près de 3000 substances organiques produites ou importées aux Etats Unis en grande quantité, les données de bases nécessaires à une évaluation du risque (santé humaine ou écotoxicité) étaient disponibles pour seulement 7% d'entre elles. Les données qui concernent les effets sur la reproduction, le développement ou la génotoxicité des substances sont encore très rares au regard du nombre de molécules chimiques existantes, alors que ce type de perturbation biologique est susceptible d'affecter à terme le développement des populations et leur sélection".

Pour plus de références et d’informations sur l’évaluation et les normes de qualité, voir "Comment Eau-Evolution évalue les contaminations chimiques et la toxicité".

Création : 19 mars 2009

Dernière actualisation :

Prélèvement d’eau

Milieux

On peut prélever de l’eau dans les milieux aquatiques superficiels (cours d’eau, plans d’eau, zones humides, etc.) ou dans les nappes souterraines (nappes libres, nappes alluviales, nappes profondes, etc.).Eau brute/eau traitée

L’eau prélevée dans la nature est de l’eau brute. Lorsqu’elle est traitée en vue d’un usage particulier, elle devient de l’eau traitée.Exemple : l’eau brute est traitée dans une station de traitement de l’eau potable avant d’être distribuée. L’eau au robinet est de l’eau traitée.

Qualité d’un prélèvement

La qualité d’une analyse est d’abord conditionnée par la qualité du prélèvement d’eau. Cette qualité dépend des conditions dans lesquelles il est fait (saison, débit, heure, profondeur, etc.), de la technique de prélèvement (lavage du piézomètre, flacon, préleveur, etc.) et des conditions de sa conservation jusqu’au moment de l’analyse (froid, délai, etc.).Analyses

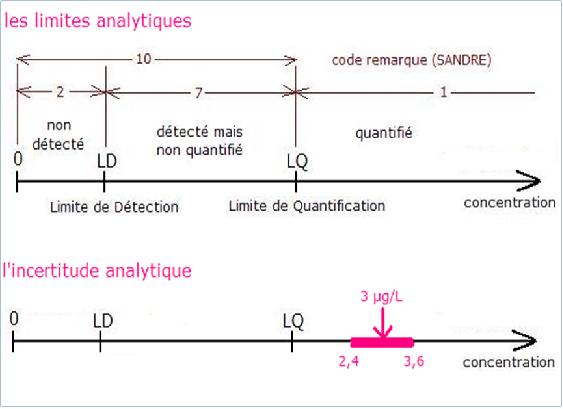

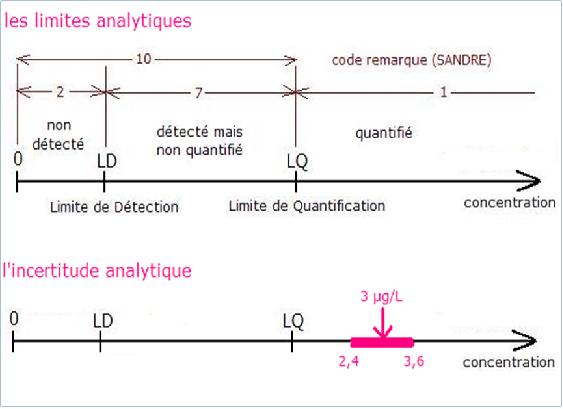

La qualité et l’efficacité d’une analyse chimique repose sur les notions de limites analytiques et d’incertitude analytique. Plus ces valeurs sont basses, plus la méthode est performante.Limites analytiques

La limite de détection (LD) est la plus petite concentration détectable dans un échantillon donné.La limite de quantification (LQ) est la plus petite concentration à partir de laquelle on peut quantifier la substance avec une incertitude acceptable.

La LQ peut être de 3 à 10 fois supérieure à la LD.

En matière de limites analytiques, l'information "< LD" ou "< LQ" contenue dans les données brutes sur l'eau ne correspond malheureusement pas aux définitions théoriques des limites de détection (LD) ou de quantification (LQ) : "En pratique, les laboratoires ne font pas la distinction entre limite de détection et limite de quantification et la seule information disponible aujourd’hui est la limite de quantification" (SOeS 2010). Il est nécessaire d'en tenir compte lorsque l'on souhaite analyser et exploiter ces données.

Incertitude analytique

Tout résultat d’analyse comporte une incertitude de mesure qui est une imprécision liée à la fois à la qualité du prélèvement et à la qualité de l’analyse. Elle va de 20 à 60% pour certaines analyses.Exemple : on a quantifié 3 µg/L de Glyphosate dans l’eau. On devrait préciser : 3 ± 0,6 µg/L. Car la concentration réelle n’est pas forcément de 3 µg/L. on peut seulement affirmer qu’elle est comprise entre 2,4 µg/L et 3,6 µg/L.

L’incertitude analytique devrait aussi s’appliquer aux limites analytiques.

La qualité chimique de l’eau : méthodes d’évaluation et normes de qualité

L’évaluation de la qualité chimique

Une évaluation patrimoniale est une évaluation qui permet d'apprécier le niveau de dégradation de la ressource indépendamment de toute référence à un quelconque usage. Elle respecte un minimum le principe de précaution. Une connaissance patrimoniale de l'état des eaux s'oppose à une connaissance anthropocentrique à court terme de son aptitude à différents usages comme par exemple la fourniture d'eau potable.La réglementation fixe des seuils à ne pas dépasser. Ils correspondent le plus souvent à des usages (classe de qualité "bonne" pour le SEQ eau potable) mais peuvent être ou du moins paraître patrimoniaux (classe de qualité "bonne" pour le SEQ patrimonial eau souterraine, "bon état chimique" pour la DCE, etc.).

Les seuils patrimoniaux ne sont donc pas établis par l'usage auquel on destine la ressource, par le montant des travaux à faire pour être respectés, ou par toute autre vision anthropocentrique. Ils doivent prendre en compte tous les aspects de la connaissance scientifique des écosystèmes aquatiques, des relations entre l'état des eaux et le maintien de la biodiversité, etc. Ce qui se traduit forcément par des valeurs très basses.

Il y a schématiquement deux types de méthodes complémentaires pour l’évaluation de la qualité chimique à partir des données brutes sur l’eau :

-De façon à être accessibles à tous les gestionnaires, les méthodes utilisées pour les évaluations réglementaires sont généralement des techniques de calculs assez simplistes (moyenne annuelle, percentile 90, etc.) avec des critères de sélection tout aussi simplistes (4 mesures de pesticides par an, etc.). Pour pouvoir évaluer des tendances, il est souvent fait appel à une gradation des détériorations selon plusieurs classes de qualité préétablies (5 classes du SEQ, 5 classes pour l'état écologique de la DCE, etc.). Mais il ne faut pas confondre les objectifs en terme de dépassement de seuils avec le principe de l'utilisation de classes de qualité qui permettraient éventuellement de calculer des tendances acceptables à condition qu'elles soient bien conçues, qu'elles aient du sens et que les limites de ces classes soient patrimoniales et donc suffisamment basses.

-Les méthodes utilisées pour les évaluations patrimoniales font appel à l'arsenal des méthodes modernes de la statistique et de l'analyse des données multidimensionnelles pour visualiser et analyser les niveaux de contamination et leurs évolutions. Ce qui n’empêche nullement de comparer les niveaux de dégradation ainsi obtenus aux seuils réglementaires.

Les approches type "SEQ" ou "bon état chimique" DCE sont des approches de gestionnaire orientées vers l'efficacité à court terme. Elles sont faciles à mettre en œuvre et ne demandent pas une surveillance très lourde. Mais en contrepartie, elles restent très peu performantes et pertinentes, particulièrement pour les micropolluants. Elles ne peuvent donc être qu'un complément de l'approche patrimoniale "statistique et analyse des données" qui est la seule approche réellement adaptée à la gestion sur le long terme d’une ressource patrimoniale. Cette approche patrimoniale permet la connaissance approfondie de la ressource et la compréhension du fonctionnement et des évolutions à long terme des écosystèmes. Elle permet de mettre en évidence la dégradation des milieux par rapport à l'état de référence qui est "zéro contamination" pour les polluants chimiques synthétiques, ou d'établir un lien entre les substances chimiques et les phénomènes de toxicité constatés. Elle exige malheureusement une surveillance extrêmement complète et précautionneuse, avec en particulier l'utilisation de limites analytiques les plus basses possibles, de fréquences de mesures élevées et adaptées à la variabilité des concentrations, etc.

Les normes de qualité environnementale

La concentration sans effet prévisible (PNEC) est la concentration maximale pour laquelle il n'est pas attendu d'effet sur l'ensemble des organismes aquatiques. Elle prend en compte l'ensemble des informations disponibles.La norme de qualité environnementale (NQE) est "la concentration d'un polluant ou d'un groupe de polluants dans l'eau, les sédiments ou le biote qui ne doit pas être dépassée, afin de protéger la santé humaine et l'environnement" (Directive n° 2000/60/CE du Parlement européen et du Conseil du 23 octobre 2000 établissant un cadre pour une politique communautaire dans le domaine de l'eau).

Pour chaque substance, la LQ devrait être très inférieure à la NQE de façon à pouvoir être suivre l’évolution de la contamination et prendre les mesures nécessaires.

Quelques observations sur ces normes :

Elles ont un caractère assez empirique et évolutif.

On ne connaît en réalité pas grand chose en écotoxicologie des milieux aquatiques, que ce soit pour évaluer la toxicité à court et à long terme ou la biodisponibilité des micropolluants ainsi que leur comportement dans l'eau.

Et en admettant que l'on ait tout pris en compte pour définir un seuil de toxicité, le changement climatique avec en particulier les changements des températures et des débits remettra tout en question : la toxicité sera forcément plus importante à température de l'eau plus élevée et moins d'oxygène dissous dans l'eau, la température influencera aussi la biodisponibilité, etc.

Les PNEC et les NQE sont souvent extrapolées à partir des maigres données existantes sur un nombre très limité d'organismes aquatiques, avec un facteur de sécurité arbitraire pour prendre en compte les impacts possibles sur les autres organismes. Elles doivent être réajustées en fonction des nouvelles études. De plus, ces données résultent souvent d'essais in vitro, avec de l'eau filtrée. La réalité de la toxicité in situ peut être très différente. Et enfin, et surtout, elles ne tiennent pas compte des effets synergiques dus à la présence de plusieurs toxiques dans l'eau, ou à des facteurs climatiques particuliers.

Une étude de l'Agence de l'Eau RMC précise : "Quelque soit la méthode mise en œuvre pour classer les substances et évaluer leur dangerosité, la qualité des informations écotoxicologiques est un point clé de l'évaluation du risque. A ce jour ce sont essentiellement des données issues de biotests réalisés sur un petit nombre d'organismes aisément accessibles aux expérimentations qui sont utilisées. Ces données à la base du calcul de la PNEC sont ensuite corrigées d'un facteur de sécurité (entre 10 et 1000) pour tenir compte de la faible représentativité des données biologiques disponibles. En effet, par exemple, pour les substances existantes et largement présentes dans l'environnement on ne dispose encore trop souvent que de rares informations sur leur écotoxicité et le plus souvent sur des effets létaux. Une récente étude de l'agence de protection de l'environnement américaine a ainsi conclu que pour près de 3000 substances organiques produites ou importées aux Etats Unis en grande quantité, les données de bases nécessaires à une évaluation du risque (santé humaine ou écotoxicité) étaient disponibles pour seulement 7% d'entre elles. Les données qui concernent les effets sur la reproduction, le développement ou la génotoxicité des substances sont encore très rares au regard du nombre de molécules chimiques existantes, alors que ce type de perturbation biologique est susceptible d'affecter à terme le développement des populations et leur sélection".

Pour plus de références et d’informations sur l’évaluation et les normes de qualité, voir "Comment Eau-Evolution évalue les contaminations chimiques et la toxicité".

Création : 19 mars 2009

Dernière actualisation :

Commentaires (fermés depuis mars 2014)

Webmaster, le 2013-01-30 11:19:15

Un article intéressant sur l'impact du réchauffement climatique sur les poissons des eaux côtières et marines, "Des poissons plus petits et moins nombreux dans les 50 ans à venir" (http://www.20minutes.fr/article/1090255/poissons-plus-petits-moins-nombreux-50-ans-a-venir), résumé : "On sait déjà que les activités humaines font rétrécir les poissons, mais cela va aussi les rendre plus vulnérables aux prédateurs et, au bout du compte, menacer une ressource alimentaire cruciale pour l'espèce humaine, mettent en garde des chercheurs." Quelques extraits de cet article :

"Les scientifiques ont déjà observé et étudié comment la pêche industrielle, en prélevant les spécimens les plus gros, et le réchauffement climatique, en abaissant la teneur en oxygène des océans, réduisaient la taille moyenne des poissons.

Mais les conséquences globales et à long terme de ce phénomène restent encore méconnues.

Une équipe de chercheurs australiens et finlandais a modélisé par informatique ce rétrécissement progressif sur les cinquante ans à venir pour tenter de comprendre quel en serait l'impact sur la population de cinq espèces de poissons du Pacifique.

Ils en sont arrivés à la conclusion que, même avec une taille réduite de seulement 4% en moyenne, le taux de mortalité lié aux prédateurs pouvait augmenter jusqu'à 50%. Cela réduirait en proportion les prises des pêcheurs, avertissent-ils dans la revue Biology Letters de l'Académie des sciences britannique.

«Même une légère diminution de la taille d'une espèce de poisson peut avoir des effets importants sur leur mortalité naturelle», insistent les chercheurs.

Leurs calculs portent sur cinq espèces couramment pêchées par les chalutiers australiens, parmi lesquelles le hoki, aussi connu sous le nom de merlu à longue queue, l'abadèche rose ou une variété de poisson-crocodile.

Selon leurs modèles, la masse totale de chaque espèce perdrait entre 5% et 35%, à l'exception du hoki. Si la taille moyenne de ce poisson se réduit bien elle aussi, le nombre de hokis augmenterait de 10% tandis qu'ils se rapprocheraient des zones côtières pour mieux échapper à leurs prédateurs.

Pour les chercheurs, il ne fait aucun doute que l'Homme est en train de changer les écosystèmes marins sur toute la planète, directement via la pêche et indirectement à cause du réchauffement climatique.

«Les pratiques qui ignorent les changements actuels risquent de surestimer les ressources à long terme et d'aboutir à leur surexploitation», insistent les auteurs de l'étude."

Cet impact thermique existe a priori aussi dans les eaux douces continentales, et pas que pour les poissons… avec quel impact sur l'écotoxicité et ses normes de qualité déjà si contestables et d'autant plus contestables lorsqu'elles sont utilisées pour piloter la surveillance de la ressource en eau ?

Un article intéressant sur l'impact du réchauffement climatique sur les poissons des eaux côtières et marines, "Des poissons plus petits et moins nombreux dans les 50 ans à venir" (http://www.20minutes.fr/article/1090255/poissons-plus-petits-moins-nombreux-50-ans-a-venir), résumé : "On sait déjà que les activités humaines font rétrécir les poissons, mais cela va aussi les rendre plus vulnérables aux prédateurs et, au bout du compte, menacer une ressource alimentaire cruciale pour l'espèce humaine, mettent en garde des chercheurs." Quelques extraits de cet article :

"Les scientifiques ont déjà observé et étudié comment la pêche industrielle, en prélevant les spécimens les plus gros, et le réchauffement climatique, en abaissant la teneur en oxygène des océans, réduisaient la taille moyenne des poissons.

Mais les conséquences globales et à long terme de ce phénomène restent encore méconnues.

Une équipe de chercheurs australiens et finlandais a modélisé par informatique ce rétrécissement progressif sur les cinquante ans à venir pour tenter de comprendre quel en serait l'impact sur la population de cinq espèces de poissons du Pacifique.

Ils en sont arrivés à la conclusion que, même avec une taille réduite de seulement 4% en moyenne, le taux de mortalité lié aux prédateurs pouvait augmenter jusqu'à 50%. Cela réduirait en proportion les prises des pêcheurs, avertissent-ils dans la revue Biology Letters de l'Académie des sciences britannique.

«Même une légère diminution de la taille d'une espèce de poisson peut avoir des effets importants sur leur mortalité naturelle», insistent les chercheurs.

Leurs calculs portent sur cinq espèces couramment pêchées par les chalutiers australiens, parmi lesquelles le hoki, aussi connu sous le nom de merlu à longue queue, l'abadèche rose ou une variété de poisson-crocodile.

Selon leurs modèles, la masse totale de chaque espèce perdrait entre 5% et 35%, à l'exception du hoki. Si la taille moyenne de ce poisson se réduit bien elle aussi, le nombre de hokis augmenterait de 10% tandis qu'ils se rapprocheraient des zones côtières pour mieux échapper à leurs prédateurs.

Pour les chercheurs, il ne fait aucun doute que l'Homme est en train de changer les écosystèmes marins sur toute la planète, directement via la pêche et indirectement à cause du réchauffement climatique.

«Les pratiques qui ignorent les changements actuels risquent de surestimer les ressources à long terme et d'aboutir à leur surexploitation», insistent les auteurs de l'étude."

Cet impact thermique existe a priori aussi dans les eaux douces continentales, et pas que pour les poissons… avec quel impact sur l'écotoxicité et ses normes de qualité déjà si contestables et d'autant plus contestables lorsqu'elles sont utilisées pour piloter la surveillance de la ressource en eau ?

Webmaster, le 2013-07-01 12:17:32

"Repenser l'évaluation des risques"… à lire dans "Les polluants alimentaires accentuent les troubles du métabolisme" (http://www.lemonde.fr/planete/article/2013/06/28/les-polluants-alimentaires-accentuent-les-troubles-du-metabolisme_3438689_3244.html). Extraits :

"L'exposition chronique d'un organisme à des doses infimes de certains polluants, peut-elle avoir des effets importants ? Posée depuis près de deux décennies aux toxicologues et aux évaluateurs du risque, cette question n'en finit plus de recevoir des réponses – positives – de la recherche académique. Les travaux menés des chercheurs du Laboratoire en cardiovasculaire, métabolisme, diabétologie et nutrition (Inserm, INRA et université Lyon-1) et publiés dans la dernière édition de FASEB Journal – la revue des sociétés américaines de biologie expérimentale – en sont une nouvelle illustration. Ces derniers montrent qu'un mélange de contaminants courants, à des doses fréquemment rencontrées dans l'alimentation humaine, aggrave significativement les troubles métaboliques induits par une alimentation trop riche.

Les auteurs ont soumis des souris femelles à un tel régime "obésogène" associé à un cocktail de bisphénol A, de TCDD (une dioxine), de PCB 153 (un pyralène) et de DEHP (un phtalate). Elles ont donné naissance à des animaux qui, dès le sevrage, ont à leur tour été exposés au même régime alimentaire – contaminants compris. Ces animaux ont été comparés à d'autres rongeurs nés et nourris dans des conditions identiques, à ceci près que ni eux ni leur mère n'ont été en contact avec les quatre contaminants.

"Nous nous sommes placés dans les conditions que nous estimons les plus réalistes, les plus proches de la situation à laquelle l'homme est confronté, expliquent Danielle Naville et Brigitte Le Magueresse, qui ont coordonné ces recherches. D'une part, les doses que nous avons choisies pour chacune des quatre molécules est très faible, à des niveaux proches des doses journalières tolérables. D'autre part, nous avons choisi une exposition des animaux permanente, depuis le moment de leur conception, car les humains sont exposés en permanence, par leur alimentation notamment, à ce type de molécules."

UN COCKTAIL DE PERTURBATEURS ENDOCRINIENS

Les quatre composants du cocktail sont tous des perturbateurs endocriniens avérés – des molécules capables d'interférer avec le système hormonal – mais appartiennent à des familles différentes, ayant des modes d'action distincts."Généralement, ces molécules sont testées séparément, précise Mme Le Magueresse. Chose qui n'avait jamais été faite auparavant, nous avons évalué l'effet de leur mélange, tel qu'il peut intervenir dans l'alimentation humaine."

L'effet mis en évidence par les chercheurs français dépend du sexe des rongeurs. Chez les femelles, l'exposition au cocktail de contaminants altère la capacité de l'organisme à réguler le taux de glucose dans le sang. Attention : par rapport aux femelles nourries avec un régime alimentaire équilibré, les femelles obèses présentent les signes de cette "intolérance au glucose", même en l'absence du fameux mélange de polluants. Mais lorsque celui-ci est ajouté, le trouble métabolique s'aggrave encore. Dans la population humaine, l'intolérance au glucose est l'une des composantes du "syndrome métabolique", qui accroît les risques de diabète de type 2, d'accidents vasculaires, etc.

Les auteurs apportent en outre une explication mécanistique au phénomène observé. Dans le foie des femelles exposées au cocktail, un gène (dit Sult1e1) est surexprimé et produit ainsi plus d'une enzyme impliquée dans l'inactivation des œstrogènes. Plus cette enzyme est abondante, plus le taux de ces hormones chute, dans le foie. Selon les auteurs, c'est le déficit de ces hormones qui accentue, chez ces rongeurs femelles, l'altération du métabolisme observée. De précédents travaux, conduits par Wen Xie (université de Pittsburgh, Etats-Unis) et publiés en 2012 dans la revue Diabètes, ont mis en évidence, là encore sur des souris femelles, cet effet "protecteur" des œstrogènes.

Chez les mâles c'est une autre histoire. Les effets, moins marqués, sont une altération du métabolisme du cholestérol.

Dans ces troubles, quelle est la part respective de chacun des quatre polluants du mélange ? Les auteurs ne peuvent le dire. Pas plus qu'ils ne peuvent savoir si les effets de chacun se cumulent, s'annulent partiellement ou se renforcent..."Néanmoins, nous avons démontré l'existence d'un effet induit par l'exposition à un mélange de très faibles doses de contaminants alimentaires, concluent-ils. Cette étude contribue à alimenter la réflexion sur la manière de repenser l'évaluation des risques, telle qu'elle est pratiquée à ce jour.""

"Repenser l'évaluation des risques"… à lire dans "Les polluants alimentaires accentuent les troubles du métabolisme" (http://www.lemonde.fr/planete/article/2013/06/28/les-polluants-alimentaires-accentuent-les-troubles-du-metabolisme_3438689_3244.html). Extraits :

"L'exposition chronique d'un organisme à des doses infimes de certains polluants, peut-elle avoir des effets importants ? Posée depuis près de deux décennies aux toxicologues et aux évaluateurs du risque, cette question n'en finit plus de recevoir des réponses – positives – de la recherche académique. Les travaux menés des chercheurs du Laboratoire en cardiovasculaire, métabolisme, diabétologie et nutrition (Inserm, INRA et université Lyon-1) et publiés dans la dernière édition de FASEB Journal – la revue des sociétés américaines de biologie expérimentale – en sont une nouvelle illustration. Ces derniers montrent qu'un mélange de contaminants courants, à des doses fréquemment rencontrées dans l'alimentation humaine, aggrave significativement les troubles métaboliques induits par une alimentation trop riche.

Les auteurs ont soumis des souris femelles à un tel régime "obésogène" associé à un cocktail de bisphénol A, de TCDD (une dioxine), de PCB 153 (un pyralène) et de DEHP (un phtalate). Elles ont donné naissance à des animaux qui, dès le sevrage, ont à leur tour été exposés au même régime alimentaire – contaminants compris. Ces animaux ont été comparés à d'autres rongeurs nés et nourris dans des conditions identiques, à ceci près que ni eux ni leur mère n'ont été en contact avec les quatre contaminants.

"Nous nous sommes placés dans les conditions que nous estimons les plus réalistes, les plus proches de la situation à laquelle l'homme est confronté, expliquent Danielle Naville et Brigitte Le Magueresse, qui ont coordonné ces recherches. D'une part, les doses que nous avons choisies pour chacune des quatre molécules est très faible, à des niveaux proches des doses journalières tolérables. D'autre part, nous avons choisi une exposition des animaux permanente, depuis le moment de leur conception, car les humains sont exposés en permanence, par leur alimentation notamment, à ce type de molécules."

UN COCKTAIL DE PERTURBATEURS ENDOCRINIENS

Les quatre composants du cocktail sont tous des perturbateurs endocriniens avérés – des molécules capables d'interférer avec le système hormonal – mais appartiennent à des familles différentes, ayant des modes d'action distincts."Généralement, ces molécules sont testées séparément, précise Mme Le Magueresse. Chose qui n'avait jamais été faite auparavant, nous avons évalué l'effet de leur mélange, tel qu'il peut intervenir dans l'alimentation humaine."

L'effet mis en évidence par les chercheurs français dépend du sexe des rongeurs. Chez les femelles, l'exposition au cocktail de contaminants altère la capacité de l'organisme à réguler le taux de glucose dans le sang. Attention : par rapport aux femelles nourries avec un régime alimentaire équilibré, les femelles obèses présentent les signes de cette "intolérance au glucose", même en l'absence du fameux mélange de polluants. Mais lorsque celui-ci est ajouté, le trouble métabolique s'aggrave encore. Dans la population humaine, l'intolérance au glucose est l'une des composantes du "syndrome métabolique", qui accroît les risques de diabète de type 2, d'accidents vasculaires, etc.

Les auteurs apportent en outre une explication mécanistique au phénomène observé. Dans le foie des femelles exposées au cocktail, un gène (dit Sult1e1) est surexprimé et produit ainsi plus d'une enzyme impliquée dans l'inactivation des œstrogènes. Plus cette enzyme est abondante, plus le taux de ces hormones chute, dans le foie. Selon les auteurs, c'est le déficit de ces hormones qui accentue, chez ces rongeurs femelles, l'altération du métabolisme observée. De précédents travaux, conduits par Wen Xie (université de Pittsburgh, Etats-Unis) et publiés en 2012 dans la revue Diabètes, ont mis en évidence, là encore sur des souris femelles, cet effet "protecteur" des œstrogènes.

Chez les mâles c'est une autre histoire. Les effets, moins marqués, sont une altération du métabolisme du cholestérol.

Dans ces troubles, quelle est la part respective de chacun des quatre polluants du mélange ? Les auteurs ne peuvent le dire. Pas plus qu'ils ne peuvent savoir si les effets de chacun se cumulent, s'annulent partiellement ou se renforcent..."Néanmoins, nous avons démontré l'existence d'un effet induit par l'exposition à un mélange de très faibles doses de contaminants alimentaires, concluent-ils. Cette étude contribue à alimenter la réflexion sur la manière de repenser l'évaluation des risques, telle qu'elle est pratiquée à ce jour.""

Webmaster, le 2014-02-27 06:24:51

Toute la question concerne, comme d'habitude dans ce domaine, le niveau d'exigence ou plutôt de laxisme de la définition retenue pour caractériser le caractère perturbateur endocrinien d'une substance chimique… Cf. "2014, année de la stratégie sur les perturbateurs endocriniens ?" (http://www.actu-environnement.com/ae/news/rapport-information-roumegas-assemblee-definition-strategie-perturbateurs-endocriniens-france-europe-20899.php4). Extraits :

"Un rapport parlementaire appelle le gouvernement et l'UE à adopter la stratégie sur les perturbateurs endocriniens prévue fin 2013, pointant leurs risques majeurs. Reste à élaborer les critères pour définir ces substances. Ce qui relève du défi."

"L'UE avait prévu d'adopter sa Stratégie PE et ses critères d'ici la fin de l'année 2013 mais cette échéance n'a pas été tenue. Aucune indication de calendrier n'est connue à ce jour. Le point d'achoppement ? L'élaboration d'une définition consensuelle des perturbateurs endocriniens. Or celle-ci est essentielle à l'établissement du cadre réglementaire afin d'améliorer la surveillance et la gestion de ces substances chimiques, susceptibles d'interférer avec la régulation des hormones. La question clef reste la définition du "caractère perturbateur endocrinien" que la Commission européenne devait finaliser pour décembre 2013 alors que plusieurs législations européennes (directive sur les biocides, règlement Reach sur les produits chimiques, règlement sur la mise sur le marché des produits phytopharmaceutiques) prévoyaient un retrait du marché des PE les plus dangereux dès 2013. Les perturbateurs endocriniens sont définis par l'Organisation mondiale de la Santé (OMS) comme des substances chimiques d'origine naturelle ou artificielle étrangères à l'organisme, qui peuvent interférer avec le fonctionnement du système hormonal. Ils sont tous liés à "des objets familiers de notre quotidien et sont systématiquement présents" dans l'environnement et le corps humain (urines, sang, cordon ombilical, lait maternel), explique le rapporteur en citant le bisphénol (tickets de caisse, biberons, contenants alimentaires), les phtalates, (revêtement du sol, matériel médical), ou encore les parabènes (produits cosmétiques) ou les pesticides agricoles. Les enjeux autour de la définition des perturbateurs endocriniens à exclure sont des plus importants pour les secteurs de l'industrie, la santé et l'agriculture car elle servira de base à ces législations. Dans son rapport, M. Roumegas juge "indispensable" que l'Union européenne se dote "au plus vite" d'une définition unique des perturbateurs endocriniens, fondée sur le "critère de danger intrinsèque", incluant substances "avérées" et substances "suspectées", afin d'en faire "une classe distincte des autres produits chimiques toxiques ". Cette définition devra être "unique et faire autorité pour toutes les politiques sectorielles, quels que soient les usages des substances"."

"Jean-Louis Roumegas s'est appuyé sur les travaux du Professeur Andreas Kortemkamp qui confirment les "risques majeurs" sur la santé humaine et les générations futures. Le rapport "Kortemkamp" de 2011 revient sur les avancées scientifiques enregistrées depuis 2002 et trace "des pistes" pour traiter la question des PE dans l'appareil réglementaire européen relatif aux produits chimiques. Il établit que les preuves "de la tendance à la hausse des désordres endocriniens chez l'homme se sont renforcées au cours des deux décennies passées". Les périodes d'exposition "les plus problématiques" sont la vie prénatale (fœtus), la petite enfance et la puberté. L'effet des perturbateurs endocriniens peut se manifester "quelques années" voire "plusieurs décennies" après l'exposition, ajoute le rapporteur. Leur "nocivité" tient à deux effets "multipliant le risque" : l'effet cumulatif (PE qui se trouvent dans des produits différents) et l'effet cocktail (interaction entre les molécules différentes). Andreas Kortemkamp récuse l'emploi des seuils d'exposition "rigides comme critères décisifs" et préconise une définition des perturbateurs endocriniens qui soit "uniquement fondée sur le critère de nocivité au regard des modes d'action endocriniens". Une définition approuvée par un "consensus scientifique" : une substance doit être classée parmi les PE "en fonction de ses caractéristiques intrinsèques de dangerosité et non du risque qu'elle fait peser à partir d'une dose d'exposition donnée", a souligné le député. La distinction entre perturbateurs endocriniens avérés et suspectés "font aussi l'objet d'un consensus scientifique". Cette distinction "a l'aval des autorités françaises" qui considèrent que des tests in vitro "peuvent suffire pour faire entrer une substance dans la seconde catégorie"."

"En France, l'adoption de sa stratégie était attendue l'automne dernier. Le texte devrait être présenté devant le Conseil national de la transition écologique," lors de sa réunion d'avril 2014", a précisé M. Roumegas. Les associations de protection de la santé et de l'environnement s'inquiètent des freins mis à l'élaboration de la stratégie nationale "et de l'incertitude quant à la teneur des arbitrages ministériels en cours, d'autant que le document qui a servi de base à la consultation publique et qui constitue la dernière version du rapport du groupe de travail ne les satisfait pas totalement", a souligné le député. Le rapport appelle donc le gouvernement à "adopter rapidement" une stratégie nationale "d'un haut niveau d'exigence", notamment "en ne retenant pas la possibilité que la France puisse demander la révision des critères d'exclusion des pesticides PE", se sont félicitées les ONG Générations futures et Réseau Environnement Santé."

Toute la question concerne, comme d'habitude dans ce domaine, le niveau d'exigence ou plutôt de laxisme de la définition retenue pour caractériser le caractère perturbateur endocrinien d'une substance chimique… Cf. "2014, année de la stratégie sur les perturbateurs endocriniens ?" (http://www.actu-environnement.com/ae/news/rapport-information-roumegas-assemblee-definition-strategie-perturbateurs-endocriniens-france-europe-20899.php4). Extraits :

"Un rapport parlementaire appelle le gouvernement et l'UE à adopter la stratégie sur les perturbateurs endocriniens prévue fin 2013, pointant leurs risques majeurs. Reste à élaborer les critères pour définir ces substances. Ce qui relève du défi."

"L'UE avait prévu d'adopter sa Stratégie PE et ses critères d'ici la fin de l'année 2013 mais cette échéance n'a pas été tenue. Aucune indication de calendrier n'est connue à ce jour. Le point d'achoppement ? L'élaboration d'une définition consensuelle des perturbateurs endocriniens. Or celle-ci est essentielle à l'établissement du cadre réglementaire afin d'améliorer la surveillance et la gestion de ces substances chimiques, susceptibles d'interférer avec la régulation des hormones. La question clef reste la définition du "caractère perturbateur endocrinien" que la Commission européenne devait finaliser pour décembre 2013 alors que plusieurs législations européennes (directive sur les biocides, règlement Reach sur les produits chimiques, règlement sur la mise sur le marché des produits phytopharmaceutiques) prévoyaient un retrait du marché des PE les plus dangereux dès 2013. Les perturbateurs endocriniens sont définis par l'Organisation mondiale de la Santé (OMS) comme des substances chimiques d'origine naturelle ou artificielle étrangères à l'organisme, qui peuvent interférer avec le fonctionnement du système hormonal. Ils sont tous liés à "des objets familiers de notre quotidien et sont systématiquement présents" dans l'environnement et le corps humain (urines, sang, cordon ombilical, lait maternel), explique le rapporteur en citant le bisphénol (tickets de caisse, biberons, contenants alimentaires), les phtalates, (revêtement du sol, matériel médical), ou encore les parabènes (produits cosmétiques) ou les pesticides agricoles. Les enjeux autour de la définition des perturbateurs endocriniens à exclure sont des plus importants pour les secteurs de l'industrie, la santé et l'agriculture car elle servira de base à ces législations. Dans son rapport, M. Roumegas juge "indispensable" que l'Union européenne se dote "au plus vite" d'une définition unique des perturbateurs endocriniens, fondée sur le "critère de danger intrinsèque", incluant substances "avérées" et substances "suspectées", afin d'en faire "une classe distincte des autres produits chimiques toxiques ". Cette définition devra être "unique et faire autorité pour toutes les politiques sectorielles, quels que soient les usages des substances"."

"Jean-Louis Roumegas s'est appuyé sur les travaux du Professeur Andreas Kortemkamp qui confirment les "risques majeurs" sur la santé humaine et les générations futures. Le rapport "Kortemkamp" de 2011 revient sur les avancées scientifiques enregistrées depuis 2002 et trace "des pistes" pour traiter la question des PE dans l'appareil réglementaire européen relatif aux produits chimiques. Il établit que les preuves "de la tendance à la hausse des désordres endocriniens chez l'homme se sont renforcées au cours des deux décennies passées". Les périodes d'exposition "les plus problématiques" sont la vie prénatale (fœtus), la petite enfance et la puberté. L'effet des perturbateurs endocriniens peut se manifester "quelques années" voire "plusieurs décennies" après l'exposition, ajoute le rapporteur. Leur "nocivité" tient à deux effets "multipliant le risque" : l'effet cumulatif (PE qui se trouvent dans des produits différents) et l'effet cocktail (interaction entre les molécules différentes). Andreas Kortemkamp récuse l'emploi des seuils d'exposition "rigides comme critères décisifs" et préconise une définition des perturbateurs endocriniens qui soit "uniquement fondée sur le critère de nocivité au regard des modes d'action endocriniens". Une définition approuvée par un "consensus scientifique" : une substance doit être classée parmi les PE "en fonction de ses caractéristiques intrinsèques de dangerosité et non du risque qu'elle fait peser à partir d'une dose d'exposition donnée", a souligné le député. La distinction entre perturbateurs endocriniens avérés et suspectés "font aussi l'objet d'un consensus scientifique". Cette distinction "a l'aval des autorités françaises" qui considèrent que des tests in vitro "peuvent suffire pour faire entrer une substance dans la seconde catégorie"."

"En France, l'adoption de sa stratégie était attendue l'automne dernier. Le texte devrait être présenté devant le Conseil national de la transition écologique," lors de sa réunion d'avril 2014", a précisé M. Roumegas. Les associations de protection de la santé et de l'environnement s'inquiètent des freins mis à l'élaboration de la stratégie nationale "et de l'incertitude quant à la teneur des arbitrages ministériels en cours, d'autant que le document qui a servi de base à la consultation publique et qui constitue la dernière version du rapport du groupe de travail ne les satisfait pas totalement", a souligné le député. Le rapport appelle donc le gouvernement à "adopter rapidement" une stratégie nationale "d'un haut niveau d'exigence", notamment "en ne retenant pas la possibilité que la France puisse demander la révision des critères d'exclusion des pesticides PE", se sont félicitées les ONG Générations futures et Réseau Environnement Santé."

Webmaster, le 2014-03-06 06:07:24

Quelques raisons pour lesquelles les risques liés aux produits chimiques sont mal évalués, selon le Cnrs, cf. "Quelles politiques pour mieux évaluer les risques liés à l'innovation ?" (https://lejournal.cnrs.fr/billets/quelles-politiques-pour-mieux-evaluer-les-risques-lies-a-linnovation). Extraits :

"Pesticides, bisphénol A… De plus en plus de produits chimiques ou alimentaires s’avèrent dangereux alors qu’ils sont commercialisés depuis longtemps. Pourquoi les polémiques entre industriels et comités d’experts sont-elles si longues avant que les risques de ces produits ne soient correctement évalués ? La chercheuse Laura Maxim analyse les dysfonctionnements du système."

"Des objectifs économiques et sanitaires contradictoires

De nombreuses controverses sanitaires et environnementales remettent en cause l’évaluation des risques de certaines innovations techniques, récentes ou plus anciennes, pour la santé et l’environnement. Quand elle arrive – car elle n’a pas lieu systématiquement –, cette évaluation est tardive, alors que des investissements privés ou publics importants sont engagés, et que des bénéfices économiques sont promis ou se sont déjà concrétisés. Dans un cadre réglementaire, l’évaluation des risques a lieu juste avant ou, bien des fois, après la mise sur le marché, lorsque les États sont amenés à se prononcer sur les risques éventuels. Les pouvoirs publics se retrouvent ainsi à gérer des objectifs économiques et sanitaires contradictoires dans un cadre qui invite au rapport de forces avec le secteur privé. L’évaluation des risques de l’innovation et des produits nouveaux en général suscite ainsi plusieurs questions.

Ce sont les industriels qui financent l’évaluation des risques

La première question qui se pose est celle du financement de l’évaluation des risques. Invoquant le principe de la répartition équitable de la charge financière de la preuve, plusieurs réglementations demandent aux industriels d’évaluer les risques des produits qu’ils souhaitent mettre ou garder sur le marché. Comme ces industriels tireront des bénéfices issus de la commercialisation, il leur reviendrait de payer également les frais liés à l’évaluation de ses risques. Si d’un point de vue financier la solution trouvée semble juste, elle pose néanmoins certains problèmes. Le plus important est celui de l’influence des conflits d’intérêts. En effet, la corrélation entre l’origine du financement et des résultats favorables au financeur est aujourd’hui bien documentée dans la littérature scientifique. Pourtant, les réglementations européennes sont fondées sur l’idée d’une neutralité normative de la preuve, où la robustesse scientifique ne serait pas influencée par le financeur. L’idée d’une taxe versée par les industriels à des structures publiques qui géreraient les évaluations des risques semble donc plus adaptée, mais elle n’a pas fait son chemin jusqu’aux décisions politiques.

Vérifier les études fournies par les industriels est un casse-tête

La deuxième question est directement associée à la première et concerne la vérifiabilité par les agences sanitaires des informations soumises par l’industrie. Par exemple, lorsque des fraudes ont été constatées dans les structures privées effectuant des études toxicologiques pour le compte de l’industrie, les bonnes pratiques de laboratoire (BPL) ont été introduites pour permettre une meilleure traçabilité des opérations effectuées. Par ailleurs, des guides OCDE proposent des protocoles de test standardisés par type d’effet secondaire étudié. Un des objectifs de ces guides était donc d’encadrer la production de preuve pour garantir sa vérifiabilité. Mais ils répondent aussi à un deuxième objectif, au moins tout aussi important, voire plus, celui de l’uniformisation des approches d’évaluation du risque chimique dans le monde. Il s’agit ainsi d’empêcher les pays d’utiliser cette évaluation comme instrument pour favoriser leurs industries locales en imposant des conditions liées aux risques plus drastiques pour les concurrents, et ainsi créer des barrières au commerce international.

La recherche du consensus international aboutit à des protocoles trop vagues

Même si elle est fondée sur la science, la preuve réglementaire est essentiellement un outil politique, qui vise la gouvernance des conflits potentiels entre la vie économique et la santé des populations et de l’environnement. En effet, on prend conscience de plus en plus que le standard de qualité de la preuve réglementaire n’est pas le même que le standard de qualité scientifique. Puisqu’ils doivent faire l’objet d’un consensus international entre les divers pays membres, chacun ayant des intérêts divers dans les secteurs économiques directement ou indirectement concernés par les risques étudiés, les processus de création ou de mise à jour des guides standardisés sont très longs et ne rendent pas compte des derniers développements scientifiques.

Pour la même raison, les compromis obtenus peuvent mobiliser un langage diplomatique parfois vague pour représenter les intérêts de tous les pays concernés mais aussi pour que les guides restent assez larges dans leur objet. En effet, le même protocole doit pouvoir être utilisé pour traiter une grande diversité de situations. Par exemple, un grand nombre de substances chimiques, chacune avec son mécanisme d’action et ses spécificités d’exposition, doivent être évaluées pour leur potentiel de reprotoxicité à l’aide d’un même guide. Si l’ambiguïté linguistique s’avère ainsi utile, elle laisse également une liberté plus ou moins grande dans l’interprétation du texte des protocoles et affaiblit leur capacité de standardisation.

Les méthodes d'évaluation deviennent vite obsolètes

Les spécificités de chaque situation particulière de risque imposeraient ainsi une demande d’adaptation des protocoles, en accord avec les derniers développements scientifiques. Pour chaque innovation technologique, les nouveaux risques raisonnablement envisageables pourraient être estimés. Car les cadres existants d’évaluation, construits sur le modèle de risques passés, ne peuvent pas rendre compte de nouveaux risques, comme le montrent les débats autour de l’évaluation des risques des nanotechnologies ou des dernières générations de pesticides. De plus, la question de l’évaluation de la qualité scientifique des informations disponibles, d’origine industrielle ou académique, pose de nombreux problèmes liés à l’expertise sanitaire, à sa neutralité, ses critères, ses procédures de fonctionnement, son efficacité et son financement.

Le budget de la recherche publique est très limité

Enfin, la production de connaissances scientifiques pour évaluer les effets secondaires de l’innovation est sous-financée et en conséquence rare. Ainsi, un récent rapport européen4 a estimé à seulement 1 % le pourcentage du financement public européen de la recherche sur les risques des nanotechnologies, biotechnologies et technologies de l’information et de la communication. Les 99 % restants du financement 2002-2013 des Programmes-cadres européens sur la recherche et le développement (PCRD) étaient dédiés à la recherche visant le développement de nouveaux produits. Plusieurs réponses ont émergé au cours des dernières années dans la communauté scientifique pour répondre aux enjeux décrits dans cet article. D’abord, une nouvelle prise de conscience des enjeux éthiques, ayant comme conséquence la mise en place de filtres comme les comités d’éthique ou des mesures visant à renforcer la transparence dans les journaux scientifiques par des déclarations des liens d’intérêts. Pour remonter dans le processus de production de connaissance destinée à devenir une innovation, la recherche responsable – au sens du programme de la Commission européenne Horizon 2020 – pourrait inclure des préoccupations liées aux effets potentiels sur la santé et l’environnement très en amont, à l’étape même du travail de laboratoire, comme le montre l’exemple de la chimie verte. Ces réponses sont le reflet d’une prise de position de la communauté scientifique sur la question des effets secondaires de l’innovation. C’est un rôle d’acteur de la société, que la recherche entend renforcer à côté des industriels et des régulateurs."

Quelques raisons pour lesquelles les risques liés aux produits chimiques sont mal évalués, selon le Cnrs, cf. "Quelles politiques pour mieux évaluer les risques liés à l'innovation ?" (https://lejournal.cnrs.fr/billets/quelles-politiques-pour-mieux-evaluer-les-risques-lies-a-linnovation). Extraits :

"Pesticides, bisphénol A… De plus en plus de produits chimiques ou alimentaires s’avèrent dangereux alors qu’ils sont commercialisés depuis longtemps. Pourquoi les polémiques entre industriels et comités d’experts sont-elles si longues avant que les risques de ces produits ne soient correctement évalués ? La chercheuse Laura Maxim analyse les dysfonctionnements du système."

"Des objectifs économiques et sanitaires contradictoires

De nombreuses controverses sanitaires et environnementales remettent en cause l’évaluation des risques de certaines innovations techniques, récentes ou plus anciennes, pour la santé et l’environnement. Quand elle arrive – car elle n’a pas lieu systématiquement –, cette évaluation est tardive, alors que des investissements privés ou publics importants sont engagés, et que des bénéfices économiques sont promis ou se sont déjà concrétisés. Dans un cadre réglementaire, l’évaluation des risques a lieu juste avant ou, bien des fois, après la mise sur le marché, lorsque les États sont amenés à se prononcer sur les risques éventuels. Les pouvoirs publics se retrouvent ainsi à gérer des objectifs économiques et sanitaires contradictoires dans un cadre qui invite au rapport de forces avec le secteur privé. L’évaluation des risques de l’innovation et des produits nouveaux en général suscite ainsi plusieurs questions.

Ce sont les industriels qui financent l’évaluation des risques

La première question qui se pose est celle du financement de l’évaluation des risques. Invoquant le principe de la répartition équitable de la charge financière de la preuve, plusieurs réglementations demandent aux industriels d’évaluer les risques des produits qu’ils souhaitent mettre ou garder sur le marché. Comme ces industriels tireront des bénéfices issus de la commercialisation, il leur reviendrait de payer également les frais liés à l’évaluation de ses risques. Si d’un point de vue financier la solution trouvée semble juste, elle pose néanmoins certains problèmes. Le plus important est celui de l’influence des conflits d’intérêts. En effet, la corrélation entre l’origine du financement et des résultats favorables au financeur est aujourd’hui bien documentée dans la littérature scientifique. Pourtant, les réglementations européennes sont fondées sur l’idée d’une neutralité normative de la preuve, où la robustesse scientifique ne serait pas influencée par le financeur. L’idée d’une taxe versée par les industriels à des structures publiques qui géreraient les évaluations des risques semble donc plus adaptée, mais elle n’a pas fait son chemin jusqu’aux décisions politiques.

Vérifier les études fournies par les industriels est un casse-tête

La deuxième question est directement associée à la première et concerne la vérifiabilité par les agences sanitaires des informations soumises par l’industrie. Par exemple, lorsque des fraudes ont été constatées dans les structures privées effectuant des études toxicologiques pour le compte de l’industrie, les bonnes pratiques de laboratoire (BPL) ont été introduites pour permettre une meilleure traçabilité des opérations effectuées. Par ailleurs, des guides OCDE proposent des protocoles de test standardisés par type d’effet secondaire étudié. Un des objectifs de ces guides était donc d’encadrer la production de preuve pour garantir sa vérifiabilité. Mais ils répondent aussi à un deuxième objectif, au moins tout aussi important, voire plus, celui de l’uniformisation des approches d’évaluation du risque chimique dans le monde. Il s’agit ainsi d’empêcher les pays d’utiliser cette évaluation comme instrument pour favoriser leurs industries locales en imposant des conditions liées aux risques plus drastiques pour les concurrents, et ainsi créer des barrières au commerce international.

La recherche du consensus international aboutit à des protocoles trop vagues

Même si elle est fondée sur la science, la preuve réglementaire est essentiellement un outil politique, qui vise la gouvernance des conflits potentiels entre la vie économique et la santé des populations et de l’environnement. En effet, on prend conscience de plus en plus que le standard de qualité de la preuve réglementaire n’est pas le même que le standard de qualité scientifique. Puisqu’ils doivent faire l’objet d’un consensus international entre les divers pays membres, chacun ayant des intérêts divers dans les secteurs économiques directement ou indirectement concernés par les risques étudiés, les processus de création ou de mise à jour des guides standardisés sont très longs et ne rendent pas compte des derniers développements scientifiques.

Pour la même raison, les compromis obtenus peuvent mobiliser un langage diplomatique parfois vague pour représenter les intérêts de tous les pays concernés mais aussi pour que les guides restent assez larges dans leur objet. En effet, le même protocole doit pouvoir être utilisé pour traiter une grande diversité de situations. Par exemple, un grand nombre de substances chimiques, chacune avec son mécanisme d’action et ses spécificités d’exposition, doivent être évaluées pour leur potentiel de reprotoxicité à l’aide d’un même guide. Si l’ambiguïté linguistique s’avère ainsi utile, elle laisse également une liberté plus ou moins grande dans l’interprétation du texte des protocoles et affaiblit leur capacité de standardisation.

Les méthodes d'évaluation deviennent vite obsolètes

Les spécificités de chaque situation particulière de risque imposeraient ainsi une demande d’adaptation des protocoles, en accord avec les derniers développements scientifiques. Pour chaque innovation technologique, les nouveaux risques raisonnablement envisageables pourraient être estimés. Car les cadres existants d’évaluation, construits sur le modèle de risques passés, ne peuvent pas rendre compte de nouveaux risques, comme le montrent les débats autour de l’évaluation des risques des nanotechnologies ou des dernières générations de pesticides. De plus, la question de l’évaluation de la qualité scientifique des informations disponibles, d’origine industrielle ou académique, pose de nombreux problèmes liés à l’expertise sanitaire, à sa neutralité, ses critères, ses procédures de fonctionnement, son efficacité et son financement.

Le budget de la recherche publique est très limité

Enfin, la production de connaissances scientifiques pour évaluer les effets secondaires de l’innovation est sous-financée et en conséquence rare. Ainsi, un récent rapport européen4 a estimé à seulement 1 % le pourcentage du financement public européen de la recherche sur les risques des nanotechnologies, biotechnologies et technologies de l’information et de la communication. Les 99 % restants du financement 2002-2013 des Programmes-cadres européens sur la recherche et le développement (PCRD) étaient dédiés à la recherche visant le développement de nouveaux produits. Plusieurs réponses ont émergé au cours des dernières années dans la communauté scientifique pour répondre aux enjeux décrits dans cet article. D’abord, une nouvelle prise de conscience des enjeux éthiques, ayant comme conséquence la mise en place de filtres comme les comités d’éthique ou des mesures visant à renforcer la transparence dans les journaux scientifiques par des déclarations des liens d’intérêts. Pour remonter dans le processus de production de connaissance destinée à devenir une innovation, la recherche responsable – au sens du programme de la Commission européenne Horizon 2020 – pourrait inclure des préoccupations liées aux effets potentiels sur la santé et l’environnement très en amont, à l’étape même du travail de laboratoire, comme le montre l’exemple de la chimie verte. Ces réponses sont le reflet d’une prise de position de la communauté scientifique sur la question des effets secondaires de l’innovation. C’est un rôle d’acteur de la société, que la recherche entend renforcer à côté des industriels et des régulateurs."